활성(화)함수란 입력을 받아 활성, 비활성을 결정하는데 사용되는 함수이다.

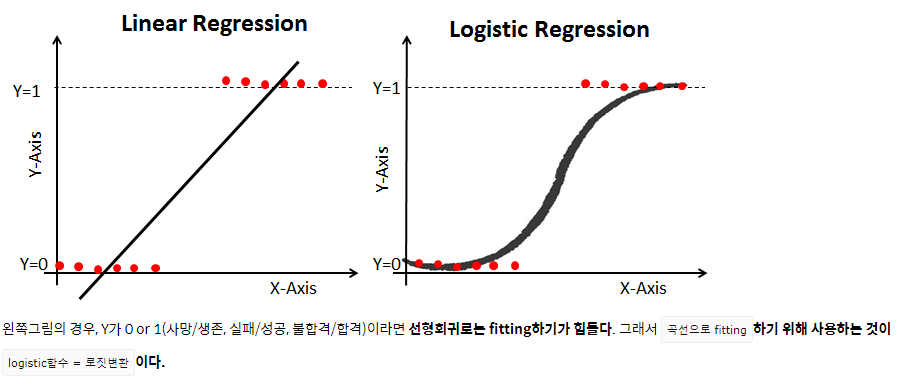

문제의 결과가 직선을 따르는 경향이 있다면 선형함수를 주로 이용한다.

2개를 분류하는 문제일 때는 Vanishing Gradient Problem때문에 sigmoid는 잘 사용하지 않고

ReLU와 그 변형된 활성화함수를 주로 이용한다.

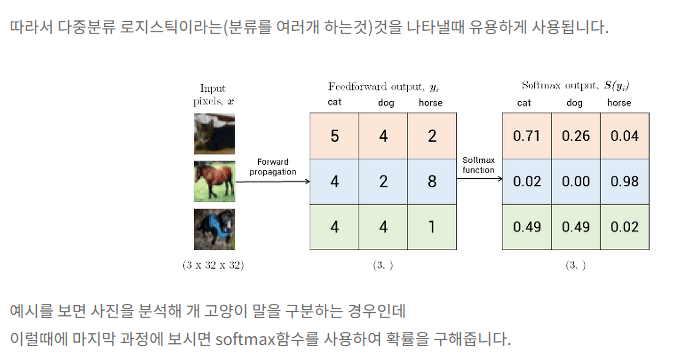

3개 이상을 분류할 때 주로 Softmax와 그 변형된 활성화함수를 주로 이용한다.

sigmoid 함수(2개 이하의 class)의 일반화 -> softmax (3개 class 이상일 때)

we can consider the softmax function as a generalization of the sigmoid function that allows us to classify more than two classes.

softmax regression ( multinomial logistic regression )

[모두의딥러닝] Logistic (Regression) Classification

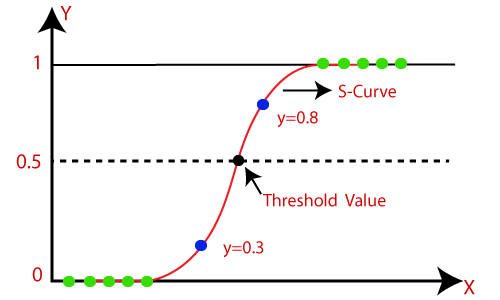

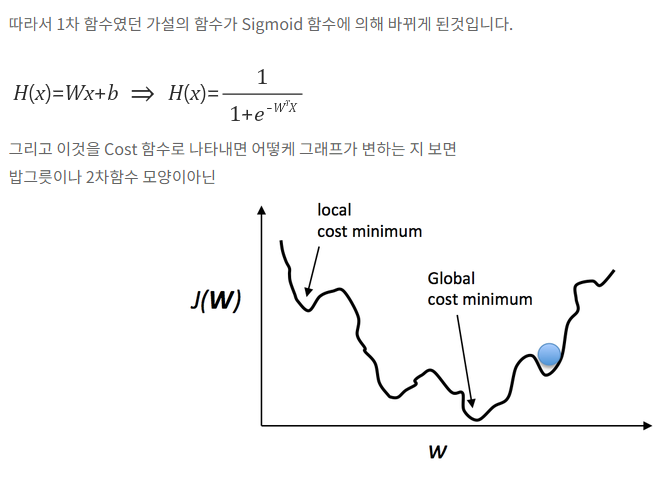

모두의 딥러닝 Logistic (Regression) Classification 강의-1 이번 강의는 Logistic Regression Classification에 대해 설명을 한다. 무엇이냐 하면, 데이터를 통해 Binary로 1 또는 0으로 분류를 하는 학습이라고..

sshkim.tistory.com

'AI > 이론' 카테고리의 다른 글

| Quantization (0) | 2020.06.23 |

|---|---|

| [ML] Supervised/Unsupervised learning (0) | 2020.06.15 |

| [ML] CNN(Convolutional Neural Network) (0) | 2020.06.12 |

| [ML] Backpropagation (0) | 2020.06.12 |

| [ML] Machine Learning training (0) | 2020.06.12 |